Le 25 juillet 2022 Nature a publié un article intitulé Automated discovery of fundamental variables hidden in experimental data dans lequel Boyuan Chen, Kuang Huang, Sunand Raghupathi, Ishaan Chandratreya, Qiang Du et Hod Lipson ont fait fonctionner une IA sur des expériences de mécanique simples, Marc Rameaux revient sur cette expérience et s’interroge : l’IA a-t-elle franchi une nouvelle étape ? Et si oui quelle en est la nature ?

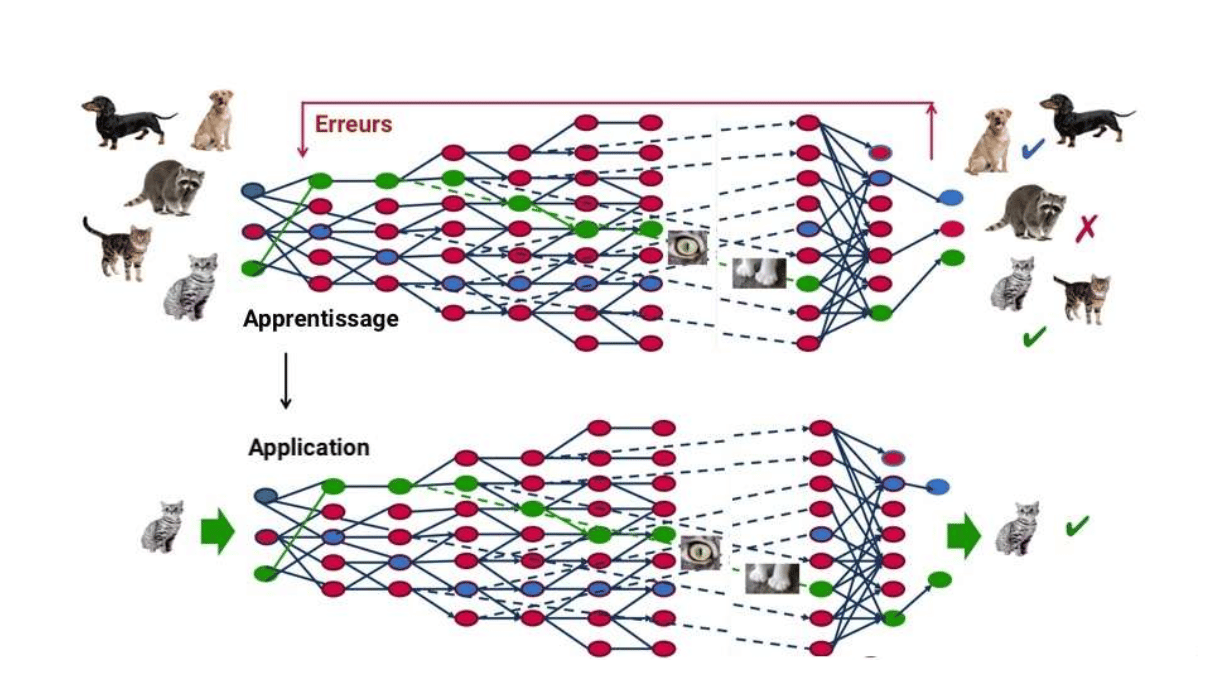

Le Deep Learning construit ses propres représentations du monde

Les applications de l’IA à la reconnaissance de formes sont devenues maintenant parties de la vie courante. Reconnaissance de l’écriture manuscrite pour le tri postal, d’images géo-satellitaires (géo-marketing, aménagement du territoire, agriculture assistée par IA), médicales (diagnostic sur imagerie médicale, recherche de nouveaux médicaments), des traits du visage (authentification, sécurité), les applications sont innombrables. Ces apports de l’IA sont cependant perçus comme une forme de « magie », accréditant l’idée que l’IA ne nécessiterait plus que l’ingestion d’un très grand nombre de données, un encodage du résultat que l’on veut obtenir, et que l’auto-organisation ferait le reste sans que l’on n’ait plus rien à y comprendre.

Ce caractère opaque et fermé du mode de fonctionnement de l’IA est inhérent à la nature du deep learning. Dans un réseau de neurones et particulièrement dans le cas des nombreuses couches intermédiaires du deep learning, seules les couches d’entrée et de sortie ont des valeurs explicites et explicables, celles que nous avons définies par l’encodage des formes à reconnaître en entrée, et celles que nous donnons comme objectif à la machine en sortie. Dans toutes les couches du milieu, règne un chaos numérique qui semble incompréhensible et ininterprétable à l’esprit humain. Le réseau de neurones construit une logique qui lui est propre et nullement anthropocentrée, pour accomplir la tâche de reconnaissance qui lui est demandée. Les couches intermédiaires « cachées » du DNN sont celle où l’IA construit sa propre logique.

Les Data Scientists ont vite cherché à percer cette barrière d’opacité du deep learning. La première raison est pratique : tout application industrielle nécessite de démontrer quel a été le mode de fonctionnement de la machine, pour des raisons de sécurité et de preuve juridique en cas de dysfonctionnement. La traçabilité et l’explicitation de ce qui a conduit à telle ou telle action devient obligatoire lorsque l’on confie à une IA la conduite d’une voiture, la régulation d’une centrale nucléaire ou l’établissement d’un diagnostic médical.

La seconde raison tient à la connaissance de l’IA elle-même : en tentant de comprendre ce que recèlent les couches cachées, l’on peut mieux expliquer comment fonctionnent les réseaux de neurones, dont la formidable efficacité est pour l’instant enfouie derrière des mots relevant de la pensée magique (auto-organisation, qualités émergentes, etc.).

La reconnaissance d’images est le domaine qui s’est le plus prêté à ouvrir cette boîte de pandore des couches cachées du DNN. L’utilisation de réseaux de convolution permet d’imposer une structure de spécialisation des neurones à certaines parties de l’image, évitant que l’information soit noyée dans une séquence indistincte de neurones tous potentiellement équivalents.

Ainsi dans le schéma ci-dessous, peut-on faire apparaître les fragments visuels que reconstitue un réseau de neurones à la vue d’une voiture. Plus l’on avance loin dans les couches cachées, plus le DNN parvient à construire par lui-même des patterns, fragments intermédiaires et coups d’œil partiels correspondant à des caractéristiques saillantes de la voiture :

Cette reconstruction a quelque chose de fascinant, car l’on constate que l’IA se construit une certaine représentation du monde pour en extraire les caractéristiques de l’objet étudié, mais selon une logique qui nous est totalement étrangère. Un être humain décomposera l’image de la voiture en roues, calandre, capot, portières, pare-chocs, vitres, phares, rétroviseurs, etc. comme autant de caractéristiques du véhicule. Dans l’image intermédiaire de droite, l’on voit que l’IA a construit ce qu’elle considère comme des caractéristiques lui permettant de reconnaître cette voiture, mais n’ayant rien à voir avec les caractéristiques qui nous semblent « naturelles ». L’IA se construit une certaine représentation du monde, totalement étrangère à nos représentations humaines.

De telles expériences mentales n’ont pas attendu l’IA pour être imaginées : l’homme s’est demandé depuis longtemps comment le monde est vu par un chien, un chat, un poisson ou une araignée. Pour une même réalité, les modes de représentation sont infinis et peuvent prendre des formes extrêmement différentes.

L’application aux grandeurs de la physique : l’article du 25 juillet 2022 de Nature

Ces premières explorations des couches cachées d’un DNN sont un domaine connu de la Data Science depuis maintenant plusieurs années. Elles sont encouragées et financées par nombre de secteurs de l’industrie, principalement ceux qui font face à des questions critiques de sécurité (nucléaire, médical, aéronautique & spatial, automobile), pour lesquels l’explicitation et la preuve de sûreté sont un élément fondamental de leur métier.

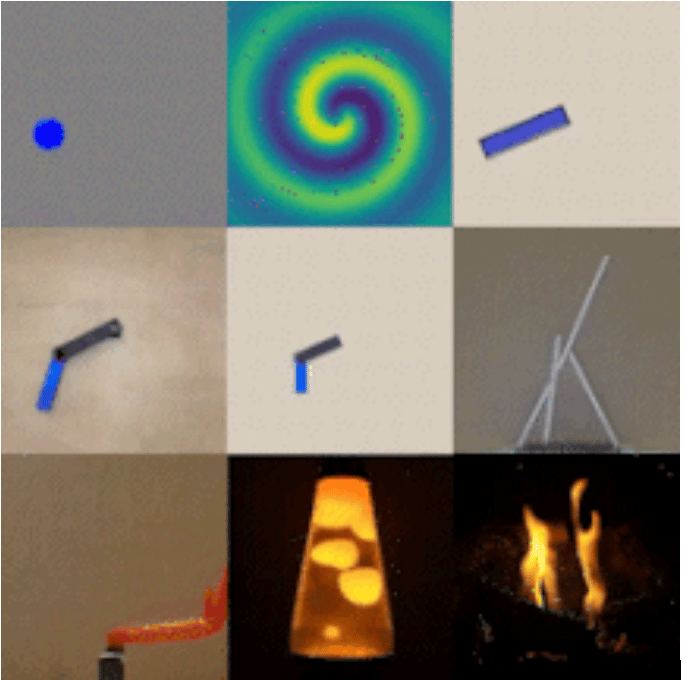

Mais une vision profonde des variables sous-jacentes au deep learning a été imaginée beaucoup plus récemment, dans un article de la section Computational Science de Nature (1). Dans Automated discovery of fundamental variables hidden in experimental data, publié le 25 juillet dernier, Boyuan Chen, Kuang Huang, Sunand Raghupathi, Ishaan Chandratreya, Qiang Du et Hod Lipson ont fait fonctionner une IA sur des expériences de mécanique simples, pour tenter d’en extraire les variables explicatives minimales. L’article de nature nécessite un abonnement, mais le travail de ces chercheurs est bien résumé dans une vidéo de 20 minutes ouverte à tous sur YouTube (2) .

L’être humain, à travers les sciences physiques, a forgé des outils d’explication des phénomènes qui l’entourent. En mécanique, les notions de vitesse, accélération, masse, inertie, quantité de mouvement, moment d’inertie, etc. ont été créées et formalisées, nécessitant plusieurs siècles pour en arriver à leur forme actuelle. Ces grandeurs de la physique nous apparaissent si naturelles qu’elles nous semblent inscrites dans le fonctionnement du monde même, indépendamment de l’être humain. En réalité, nous avons choisi ces variables comme étant les plus naturelles par rapport à notre propre système de perception des phénomènes mécaniques et notamment l’impact qu’ils peuvent avoir sur notre corps ou sur des corps absorbant des chocs.

Nous ressentons la vitesse ou l’accélération, cela ne signifie pas que la vitesse et l’accélération appartiennent intrinsèquement au monde. Ces variables qui semblent les plus simples et les plus naturelles ne sont que notre façon de décrire l’évolution des phénomènes physiques. L’expérience des auteurs de l’article montre que l’on peut fonder une physique aussi efficace que la nôtre (pouvoir prédictif identique), mais à l’aide de variables d’état totalement différentes.

Les variables d’état des sciences physiques ne sont ainsi pas une partie du monde, mais le langage dans lequel nous avons choisi de décrire les phénomènes physiques du monde. Il n’y a aucune raison que le choix de ces variables soit unique pour une description efficace de la physique, et par ailleurs les variables d’état que nous nous donnons sont intimement liées à l’ensemble de notre système de perception physiologique. Une espèce intelligente autre que l’espèce humaine pourrait fonder une physique tout aussi performante que la nôtre, mais employant des concepts et des grandeurs totalement différents et difficilement compréhensibles pour nous.

Comment l’IA élaborée par les chercheurs de l’université de Columbia a-t-elle pu extraire ainsi d’elle-même ses propres variables d’état ? La technique employée est bien connue des Data Scientists : il s’agit d’un auto-encodeur.

Ce réseau de neurones particulier consiste en deux choses : 1. Présenter en sortie du réseau, c’est à dire ce que le réseau doit prédire ou reproduire, les mêmes données que les données d’entrée. 2. “Resserrer” le réseau dans les couches du milieu, la couche centrale devant comporter bien moins de neurones que les couches d’entrée et de sortie. Un auto-encodeur se présente ainsi sous forme d’un “diabolo” :

Le but d’un auto-encodeur n’est donc pas de prédire un signal de sortie en fonction d’un signal d’entrée comme les réseaux classiques, mais de synthétiser le signal d’entrée en ses principales variables explicatives. En cela, il est une méthode de classification non supervisée, bien qu’il emploie des techniques de classification supervisée. La couche du milieu resserrée va en effet “forcer” le signal à se placer dans une plus petit nombre de variables, générant automatiquement des axes principaux qui extraient la “substantifique moelle” du signal.

L’auto-encodeur fait penser aux méthodes statistiques d’analyses factorielles, notamment l’analyse en composantes principales. L’information sous forme de nuages de points complexes est résumée à quelques axes principaux qui en capturent la plus grande partie. L’auto-encodeur réalise une extraction similaire : la couche du milieu vaut de l’or, car elle doit renfermer les principaux “concepts” qui résument toute l’information d’entrée. A noter que dans le cas d’un auto-encodeur, une partie empirique consiste à faire plusieurs essais quant à la dimension de la couche resserrée, pour déterminer le nombre de variables minimal résumant le mieux le signal. Enfin, dans l’expérience de l’article de Nature, ce n’est pas exactement le signal d’entrée qui est placé en sortie, mais sa situation à un intervalle de temps un petit peu plus loin. L’auto-encodeur va ainsi synthétiser non pas le système mécanique qu’il voit à un instant t mais sa loi d’évolution.

Une “physique alternative” ? Pas encore

Une telle expérience a quelque chose de fascinant et nous fait comprendre pourquoi certains voient déjà dans l’IA une véritable forme d’intelligence. La machine a extrait par elle-même ses propres concepts physiques, et ce de façon totalement autonome : si autonome que sa logique propre nous est d’ailleurs incompréhensible. Dans l’expérience de Nature, il faut également signaler que le nombre de variables minimal permettant de prédire le phénomène est le même entre la modélisation physique humaine et celle adoptée par la machine, simplement ces variables sont de natures très différentes. Non seulement la machine a extrait ses propres concepts, mais elle semble avoir déterminé la complexité intrinsèque de chaque problème physique qui lui a été soumis, en montrant à chaque fois qu’il s’agit d’un problème à quatre variables, six variables, 24 variables, etc.

Les plus enthousiastes ont alors clamé que l’expérience de Nature permettait de générer des “physiques alternatives”, tout aussi valables que la nôtre car de même pouvoir prédictif, mais forgées sur des concepts et des représentations du monde totalement différentes. Une physique “d’extra-terrestre” en quelque sorte. La production d’un langage privé par l’IA semble atteinte, ce qui fait dire à certains qu’elle représente bien une forme d’intelligence.

Je vais décevoir deux types de personnes : celles qui ont accueilli avec enthousiasme et sans recul l’article de Nature, clamant la naissance d’une nouvelle forme d’intelligence, et celles qui considèrent que l’article de Nature n’est qu’une bruyante communication n’apportant rien. Le résultat du travail des chercheurs de l’université de Columbia n’est pas rien et ouvre des perspectives intéressantes, même s’il n’est ni la naissance d’une véritable intelligence ni l’invention de véritables physiques alternatives.

Critique constructive de l’article de Nature : trois critiques et trois points positifs

Le travail publié dans Nature peut faire l’objet de trois principales critiques :

- Les expériences soumises au réseau de neurones sont décrites par des informations purement visuelles, sans faire intervenir par exemple les masses des objets en présence. Les modèles construits sont donc de la pure cinématique, pas de la mécanique au sens complet du terme. L’on pourrait objecter qu’en réintroduisant les masses, l’on fait de l’anthropocentrisme avec nos propres concepts de la physique. Mais cette information, le réseau en ferait cependant ce qu’il veut, reconstruisant des concepts composés en défaisant totalement la masse en tant que variable s’il le juge nécessaire. Ne pas introduire les masses ne cède donc en rien à l’anthropocentrisme, en revanche prive le réseau de neurones d’une information supplémentaire cruciale. Le résultat ne s’en est pas forcément ressenti si les objets étudiés étaient tous de masse comparable. Mais cela ne serait pas le cas dans un problème de mécanique générale. La difficulté serait facile à résoudre : avec une vue en 3D de l’expérience donnant le volume de chaque objet et l’estimation de leur densité, il serait possible d’ajouter cette information supplémentaire à la modélisation. Dans le cas présent, l’on ne voit pas ce que le réseau a “compris” du phénomène physique s’il l’a résumé à un calcul formel de trajectoires. La cinématique n’est qu’une petite partie de la mécanique.

- Les lois de la mécanique newtonienne ont une force immense qui n’est jamais assez soulignée : elles s’appliquent à n’importe quel phénomène physique, elles sont universelles (tant qu’elles restent dans des ordres de grandeur non relativistes). Il n’est pas du tout certain qu’il en est de même des modèles construits par l’IA : il peut s’agir de modèles ad’hoc, adaptés au seul mouvement d’un pendule ou d’une flamme en train de brûler. La compréhension d’un phénomène passe par le fait d’en rendre la modélisation généralisable. Dans l’article de Nature, les variables extraites lors d’une expérience ne sont pas réutilisables dans une autre expérience. L’on peut ainsi douter que l’IA ait compris quoi que ce soit au phénomène : elle ne fait que construire un modèle de corrélations entre plusieurs variables adapté à chaque problème particulier, tout comme le fait un modèle statistique classique. La même “magie” a été parfois ressentie en voyant les résultats d’une ACP bien avant que l’IA existe, car l’on a l’impression que des “concepts” émergent de terre automatiquement. En réalité, il ne s’agit que de transformations numériques.

- Corrélativement au point précédent, la machine n’a pas de recul sur le cadre dans lequel elle réalise son apprentissage. Si chaque expérience est considérée comme un jeu ou une devinette, la machine ne serait pas capable de savoir à quel moment l’on est en train de changer de jeu, ni de trouver une manière de raisonner les englobant tous, ce que fit Newton. J’ai déjà exprimé longuement dans les colonnes de TES que la véritable barrière de l’intelligence et de la conscience se situe là : l’IA a franchi la barrière du concept avec les DNN, car elle fabrique les siens propres, mais elle n’a pas franchi la barrière du contexte, lui permettant de se placer au-dessus de son propre cadre d’apprentissage et de décider par elle-même d’en changer. L’intelligence et la conscience ne sont pas question de puissance de calcul analytique ni même de capacité de synthèse, mais la capacité à sortir de soi-même de ses propres conditionnements. Aucun réseau de neurone n’est aujourd’hui capable de sortir de son propre conditionnement, de décider d’en changer et d’essayer un nouveau conditionnement plus pertinent : c’est là la tâche ardue et empirique du data scientist qui l’entraîne. C’est ce qui fait que l’intelligence même animale d’un chat ou d’un chien surpasse largement l’IA sur des tâches pragmatiques, celles intervenant dans la vie de tous les jours en environnement ouvert : face à “n’importe quoi”, le chat ou le chien répondra par une réaction pas nécessairement parfaite mais certainement beaucoup plus adaptée qu’une IA. Si l’IA de l’expérience de Nature avait fait cela, elle ne se serait pas contentée de produire un modèle efficace pour chaque expérience. Elle aurait élaboré un méta-modèle valable dans toutes et même généralisable à des expériences mécaniques qu’elle n’aurait jamais rencontrées.

Les trois critiques précédentes ont fait verser certains dans un sarcasme exagéré en sens inverse, dénigrant le travail publié comme un simple gadget numérique n’ayant aucune signification ou aucun intérêt.

Nous ne partageons pas ce dernier point de vue. Certes, les annonces bruyantes de “physique alternative” et “d’invention de nouveaux langages et nouveaux concepts de la physique par une IA” font partie de ces fantasmes médiatiques qui font sourire les véritables Data Scientists. Mais le travail réalisé par les chercheurs de Columbia présente trois intérêts qui nous semblent réels. Bien plus modestes que la construction de physiques alternatives par une intelligence. Mais représentant une avancée dans notre modélisation du monde et de ses phénomènes physiques :

- Il est déjà intéressant de voir que le nombre de variables minimal retrouvé par l’IA rejoint le nombre de variables d’état nécessité par la mécanique classique. Nous avons là une confirmation du degré de complexité de chaque problème. Et sur des situations mécaniques très complexes, l’IA pourrait continuer de fournir une valeur pertinente du nombre de variables minimal nécessaire, ce qu’une modélisation classique aurait du mal à effectuer sur un très grand nombre de systèmes. Nous en verrons un exemple concret plus loin quant à la régulation des bobines électro-magnétiques d’un Tokamak. Enfin, l’on peut mesurer tout l’intérêt si l’IA trouvait une modélisation efficace avec une variable d’état de moins que la mécanique newtonienne : cela peut être l’indice qu’une représentation plus astucieuse nous a échappé, et peut suggérer comment la trouver. Sans qu’il s’agisse d’intelligence, l’indice de complexité de Kolmogorov d’un problème semble être ce que l’IA de l’article de Nature est capable de calculer, et cela nous est précieux.

- L’expérience de Nature nous rappelle à quel point une autre représentation du monde et le langage dans lequel on la formule peuvent être différents des nôtres.

Dans l’excellent film “Premier Contact”, Denis Villeneuve imagine ce que serait une première rencontre entre humains et extra-terrestre. L’originalité du film de Villeneuve sur ce thème archi-rebattu est d’imaginer des êtres dont la représentation du monde et le langage associé sont si différents du nôtre que l’essentiel du film consiste à le décrypter. Ce qui fait dire dans l’article ci après que dans ce film, “la SF rencontre la linguistique” (3) . La rencontre est d’autant plus émouvante qu’elle nous place devant un inconnu total. Beaucoup trop de films de SF représentent les extra-terrestres comme de mauvaises séries B, employant un langage articulé inconnu mais pas fondamentalement différent d’une langue étrangère humaine. Les créatures imaginées par Villeneuve s’expriment en projetant des “tâches” circulaires, comme une pieuvre lâchant son jet d’encre, prenant des formes caractéristiques. Ces tâches en apparence désordonnées suivent dans le film une logique ultra-précise, que les humains finissent par comprendre, mettant en question notre notion même de l’écoulement du temps.

Une véritable rencontre extra-terrestre, si elle devait advenir, serait sans doute beaucoup plus proche du film de Villeneuve, c’est-à-dire un tel niveau d’étrangeté et d’incommunicabilité dans la représentation du monde qu’elle nous est à peine imaginable. Les couches cachées du DNN viennent nous rappeler à quel point il faudrait remettre en question tous nos fondamentaux linguistiques pour construire une autre représentation du monde, à quel point la communicabilité peut être différente.

Cette remise en question passe par un changement complet de perspective de ce que nous considérons comme “simple” ou “complexe”. Nous avons tendance à considérer que ce qui est simple pour nous doit faire partie de l’ordre intrinsèque de la nature ou de la logique, et devrait être compris par n’importe quelle autre intelligence aussi performante que la nôtre. Or la notion de simplicité n’a rien.. de simple et se trouve être beaucoup plus subjective que nous ne pouvons l’imaginer. Ceci est patent dans la plaque embarquée à bord des sondes Pioneer 10 et 11, “bouteille à la mer” de l’océan spatial, destinée à une intelligence extra-terrestre si par chance elle la trouvait à bord de la sonde :

Malgré tout le respect et la sympathie que l’on peut avoir pour cette tentative, la plaque de Pioneer est un condensé de tous les biais anthropocentriques qui envahissent notre inconscient sur ce qu’une autre intelligence devrait comprendre. La position du système solaire repérée à l’aide de 14 pulsars, la représentation schématique de la transition hyperfine de l’atome d’hydrogène pour définir une unité de longueur et une unité de temps, l’emploi de la codification binaire pour représenter des chiffres, supposent une formalisation des mathématiques et de la physique très proches de la nôtre. La base binaire nous semble être de toute évidence la façon la plus universelle d’écrire un nombre, une succession de 0 et de 1.

Pourtant, la discrétisation et la binarisation sont-elles l’extrême de la simplicité dans l’absolu, ou seulement pour notre espèce ? Imaginez une intelligence supérieure dans un milieu marin, par exemple celle de l’orque épaulard. Dans un milieu où les propagations d’ondes sont très différentes des nôtres, un signal tel qu’une sinusoïde amortie pourrait apparaître comme l’élément simple et basique, parce qu’il se rencontre à tout moment dans l’environnement, alors qu’il paraît déjà complexe selon nos critères :

A l’inverse, un signal binaire en créneaux, correspondant aux éléments de base pour une intelligence terrestre, le contraste tranché entre des valeurs binaires, paraîtrait très compliqué à un animal marin. Cela se comprend bien lorsque l’on cherche la représentation d’une fonction créneau en séries de Fourier. Il faut une superposition d’harmoniques de plus en plus fines, jusqu’à une fréquence très élevée pour l’approcher. Ce qui paraît simple dans un certain milieu nécessite une reconstruction complexe dans une autre :

Une intelligence qui aurait été forgée pendant des millions d’années dans un milieu où il est naturel de percevoir des harmoniques et non des unités discrètes se serait dotée d’outils, de langages et de notations qui nous paraîtraient incompréhensibles au premier abord. La traduction de leur langage dans le nôtre nous rappellerait la grande relativité des notions de “simple” ou “complexe”.

Un mérite de l’expérience de Nature est de nous rappeler la relativité de ces représentations du monde, et surtout de pouvoir en produire à volonté une multitude sans attendre de rencontrer une civilisation extra-terrestre ou de décrypter le langage des animaux les plus évolués (le langage des orques, reconnu comme encore plus complexe et élaboré que celui déjà complexe des dauphins par mesure d’entropie, est à ce jour non déchiffré) . Savoir interpréter et comprendre les couches cachées des DNN peut nous apprendre beaucoup et élargir notre horizon sur des façons de représenter le monde que nous n’aurions pas imaginées.

- Les modèles d’IA sont très loin de construire des “physiques alternatives ». En revanche, ils peuvent permettre d’élargir de 10 ou 20% l’étendue de ce que les modèles classiques de la physique nous permettent d’appréhender et de prévoir.

Une expérience remarquable récente (Février 2022) a été réalisée par des chercheurs Suisses du Swiss Plasma Center de Lausanne, en partenariat avec les équipes de Deep Mind (4) .

Ce travail a permis de contrôler les différentes configurations du plasma à l’intérieur d’un Tokamak, dans le but bien entendu de parvenir à une réaction de fusion thermonucléaire contrôlée et à rendement énergétique positif.

Les bobines électro-magnétiques utilisées dans un Tokamak peuvent être réglées pour produire des centaines de configurations extrêmement fines du champ magnétique généré. L’ajustement de ce champ est une opération extrêmement complexe devant être réalisée en temps réel. L’IA se révèle très performante pour gérer une telle combinatoire : elle permet de “façonner” le plasma de façon à optimiser la stabilité et le rendement de la réaction. Aucune méthode calculatoire classique ne parviendrait à un tel résultat.

L’IA mise en oeuvre ne réinvente pas une physique. Elle ne change en rien les fondamentaux du point d’ignition recherché pour déclencher la réaction. Mais elle construit un modèle ad’hoc qui prolonge et affine avec beaucoup plus de précision ce que nous pouvons connaître du seul calcul physique.

L’IA permet de gagner une “frange” de prédiction des phénomènes, plus poussée que celle des modèles physiques mais en extension de ceux-ci, lorsque la complexité du phénomène est telle qu’elle nécessite des modèles spécialisés. Nous avons déjà indiqué dans les colonnes de TES que c’est la raison pour laquelle l’IA apportait des contributions réelles à l’agriculture scientifique et la génétique agricole, qui nécessite des modèles “conjoncturels”, très dépendants du contexte. Les modèles de l’IA ne viennent plus en rupture complète des modèles physiques humains, mais nous offrent quelques pourcentages supplémentaires d’exploration de domaines sur lesquels nos équations sont impuissantes.

L’IA ainsi employée trouve des “chemins” ou “tunnels” au sein des lois physiques que nous connaissons, en optimisant au mieux des paramètres en très grand nombre. Pour une même situation physique donnée, l’optimisation fine des configurations en environnement de haute complexité peut faire la différence, l’astuce qui nous permettrait de passer dans le versant positif du point d’ignition, car l’on sait que cela se joue maintenant à peu de choses en matière de fusion thermonucléaire. Il ne s’agit plus nécessairement d’une course à la puissance et à la concentration d’énergie, mais d’un réglage fin de la forme du plasma qui permettra de franchir le seuil tant recherché.

Les variables cachées des DNN peuvent receler cette optimisation fine, lois physiques non universelles, adaptées à la particularité de chaque problème, mais prolongeant les modèles physiques connus en les raffinant. En sachant les interpréter, l’on connaîtrait mieux les grandeurs qu’il faut prendre en compte pour comprendre les meilleures configurations du plasma et les recréer.

Nouvelles perspectives dans les sciences physiques par un changement de point de vue ?

La meilleure utilisation de l’IA ne réside pas dans le remplacement de l’être humain par celle-ci, mais par une utilisation hybride de ses performances avec celles de l’être humain. Une IA ne crée aucune physique alternative actuellement, car elle est totalement aveugle à l’interprétation des règles qu’elle trouve, pour en faire des lois physiques à proprement parler, c’est-à -dire à portée universelle.

Le travail d’interprétation des expériences physiques, le génie d’Einstein, reste l’apanage de l’humain. En revanche l’IA peut très précieusement épauler l’humain, si nous apprenons à décrypter les variables intermédiaires qu’elle construit, comme le fait habituellement un statisticien sur les axes d’une analyse factorielle. Elle permet de prolonger un peu plus loin l’utilisation des lois physiques sur des systèmes extrêmement complexes, nécessitant une auto-régulation fine de centaines de paramètres comme le Tokamak ou nombre de phénomènes de biochimie. Et elle peut suggérer que pour certaines lois physiques connues, nous avons manqué un changement de variable astucieux qui rendrait notre modélisation plus puissante.

On sait à quel point un changement de variable bien pensé ou une nouvelle convention de notation peut simplifier la résolution mathématique d’un problème : par exemple, la notation en variables complexes des circuits électriques rend leur résolution beaucoup plus facile. L’IA ne nous dira pas explicitement quel changement variable est à effectuer, mais l’étrange algèbre qui réside dans ses couches cachées peut nous mettre sur la voie de celui-ci.

C’est cela le véritable dialogue homme-machine, celui entre l’extrême finesse d’autocalibrations que nous ne pourrions jamais effectuer par nous-mêmes, et le génie humain qui permet de les interpréter.

1) https://www.nature.com/articles/s43588-022-00281-6

2) Discovering State Variables Hidden in Experimental Data

3) https://blogterrain.hypotheses.org/12774

4) https://www.journaldugeek.com/2022/02/17/deepmind-a-appris-a-une-ia-a-controler-la-fusion-nucleaire/

Du même auteur sur l’IA

IA et OGM : les deux révélateurs de notre rapport à la nature (première partie)

Bien employée, l’IA ouvre la voie d’une nouvelle renaissance

Ouvrage de Marc Rameaux

Image par Peter Pieras de Pixabay