Nous vivons un âge d’or scientifique, un « summer of AI » aussi intense et foisonnant que le « winter of AI » fut glacial et morne. Quel contraste entre la période qui s’est étendue de la fin des années 1980 jusqu’à environ 2008, où la recherche en IA était le fait d’acharnés qui avaient le courage de poursuivre une voie que l’on disait sans issue et la période de 2008 à maintenant, pavée par l’essor des deep neural networks.

L’apparition des IA génératives et la disruption qu’a représenté ChatGPT a fait éclater une dernière barrière : celle du grand public, de la popularité commune. Si l’IA était bien connue des spécialistes en R&D dans le monde de la recherche et de l’industrie depuis 2008, elle restait une technologie d’experts, cantonnée à des tâches d’optimisation ou de détection de formes.

Depuis le lancement de ChatGPT, l’IA est perçue avec raison comme un bouleversement scientifique majeur, un changement de paradigme qui marque l’histoire humaine d’un « avant » et un « après », au même titre que la mécanique newtonienne, l’évolution des espèces ou l’apparition de l’énergie nucléaire.

L’IA n’est plus seulement une technique poussée d’optimisation ou de reconnaissance des formes, mais un principe général représentant tout autant une formidable opportunité qu’une menace. L’IA nous dote de nouvelles capacités à décupler notre productivité et à faire reculer les frontières de toutes les évolutions technologiques possibles, au point de surpasser les performances humaines dans nombre de métiers : diagnostic médical, droit des affaires, radiologie… tous les pans de l’activité humaine sont maintenant concernés. La plupart des tâches administratives courantes peuvent aujourd’hui être prise en charge par une IA, avec une fiabilité et une efficacité qui inquiète toute administration et toute politique de l’emploi.

Des domaines qui semblaient inatteignables par les moyens les plus poussés de la physique et de la simulation numérique, comme le secret du repliement des protéines ou l’optimisation des champs magnétiques confinant un plasma dans un Tokamak, deviennent atteignables grâce à l’IA. La menace sur les compétences humaines semble être la contrepartie inévitable de ces victoires dans tous les domaines de la connaissance et de l’activité humaine.

Cependant, arrivons-nous aujourd’hui à un nouveau plateau, une saturation des possibilités de l’IA ? La question semble incongrue au regard des perspectives qui viennent d’être retracées. Des limites apparaissent pourtant, parfois intrinsèques à l’IA, parfois d’ordre sociétal ou géopolitique. Sont-elles des barrières durables qui ramèneraient l’IA à une évolution technologique notable mais pas aussi disruptive que nous ne l’aurions cru ? Ou s’agit-il de nouvelles frontières à dépasser, la marque des prochaines étapes auxquelles il faut s’attendre, parachevant une révolution des esprits et des possibilités scientifiques ? L’avenir nous le dira. Voici en tous les cas les 6 frontières que nous allons rencontrer dans les années à venir.

La robustesse des IA Génératives et de l’IA de façon générale

Si les IA génératives sont employées dans de plus en plus de domaines, elles présentent encore un défaut important : lorsqu’on leur pose la même question à quelques jours d’intervalle, leur réponse peut être sensiblement différente et pas toujours dans le sens de l’amélioration ou de l’affinage des résultats. La génération d’images rencontre le même problème, la mémorisation du contexte demandé sur plusieurs « prompts » successifs étant encore peu assurée.

L’IA est un auxiliaire précieux d’accès à la connaissance et d’aide à la décision, sur une question ponctuelle à un instant donné. Qu’il s’agisse de la vérification d’un point d’histoire, de l’établissement d’un diagnostic, d’une prise de décision ou de la génération de lignes de code dans un programme, l’IA nous fait gagner un temps précieux en collectant et synthétisant une masse considérable de données éparses et en mettant en lumière des associations auxquelles nous n’aurions pas pensé.

Mais l’IA peine encore à franchir le stade de l’industrialisation en étant embarquée dans des systèmes devant assurer un contrôle et une sûreté d’exécution de haut niveau. On confie encore rarement à une IA le contrôle complet d’une chaîne d’usine ou d’un banc d’essai et encore moins les lois de commande d’une voiture, d’un train ou d’un avion. Il faut pour cela remplir deux conditions : les commandes initiées par une IA doivent être reproductibles et explicables. Cela signifie qu’elles doivent assurer une certaine stabilité dans des situations comparables et être transparentes, donc permettre de retracer les raisons qui l’ont amenée à sa décision.

Nous en sommes encore loin : l’IA peut être sujette à d’inquiétantes instabilités dans des situations où elle devrait assurer une forme de continuité de comportement.

L’un des exemples les plus connus de ce manque de robustesse est décrit par les images ci-après. Avec quelques marqueurs simples sur un panneau de Stop ou un brouillage par du bruit d’une image de panda, qui ne modifie pourtant pas ses « patterns » principaux du point de vue d’un humain, l’IA est complètement leurrée : le panneau Stop est perçu comme une limitation de vitesse et le panda identifié comme un gibbon avec plus de 99% de confiance ! :

Nous avons également tous expérimenté des situations où ChatGPT donne des réponses radicalement différentes à quelques jours d’intervalles à la même question, sans nécessairement marquer une progression, mais plutôt une saute de comportement qui le fait hésiter entre deux biais sur une question.

L’IA est employée dans certains systèmes de contrôle industriel, notamment en reconnaissance d’images, pour opérer des contrôles qualité. Mais l’on s’est assuré dans ce cas que l’univers des possibles auquel elle est confrontée est fortement limité : les conditions d’éclairage et de qualité de l’image doivent être maintenues dans des bornes très serrées. La mise en production industrielle ne devient effective que lorsque l’on s’est assuré de la robustesse du système sur des dizaines de milliers de contrôles à effectuer.

De même, le tri des enveloppes par La Poste se fait de nos jours par de la reconnaissance manuscrite par IA. Mais une vérification humaine a posteriori a toujours lieu lors de l’acheminement final de la lettre, corrigeant les derniers défauts. La robustesse de la reconnaissance manuscrite a été suffisamment éprouvée mais de façon empirique, en s’assurant que le taux de défauts dans l’acheminement manuel demeure très limité.

La robustesse de l’IA lui permet de franchir la barrière industrielle dans des univers suffisamment limités et déterministes, dont on maintient fermement les conditions sous contrôle. Dans des environnements ouverts ou semi-ouverts, tels que la conduite d’une automobile, le contrôle de systèmes industriels complexes, ou la synthèse de documents par ChatGPT, elle comporte encore une part d’aléa trop importante. Elle n’est dans ce cas utile que lorsque le regard humain vient en vérifier la pertinence au coup par coup et décide de l’utiliser seulement si elle juge le résultat meilleur que ce que le contrôle humain aurait pu faire.

Ainsi, un conducteur humain peut tantôt apprécier le comportement de son ADAS, son aide à la conduite, ou au contraire se « bagarrer » contre en donnant des coups de volant contraires, par exemple dans les dispositifs de « LKA », Lane Keep Assistant.

La traçabilité ou explicabilité de l’IA n’est pas plus garantie que sa robustesse. Une IA entraînée par DNN demeure en grande partie une boîte noire, même si des progrès ont été accomplis pour rendre un peu plus visibles et compréhensibles les couches cachées d’un réseau de neurones. La traçabilité reste cependant largement insuffisante pour répondre aux normes légales de systèmes médicaux ou de de pilotage d’un avion ou d’une voiture : en cas de défaillance, il est inadmissible de ne pas savoir pourquoi une automation a provoqué un accident responsable de la mort d’une à plusieurs centaines de personnes.

Même si statistiquement l’on parvient à prouver sur un échantillon empirique que l’IA se montre 100 fois plus fiable qu’un humain, si une mort survient l’on ne peut se contenter de la réponse que sa cause est inexplicable et qu’il s’agit du manque de chance d’être tombé sur les quelques cas résiduels où l’IA n’a pas fonctionné. D’autant que même si l’on se contentait du calcul cynique de la statistique pour le justifier, l’absence d’explication n’exclut pas que dans des conditions qui auraient changées, le taux de défaillances de l’IA ne se mette pas à exploser brusquement, causant cette fois des centaines de morts.

Lorsque des vies humaines sont en jeu, l’on ne peut se contenter des scores statistiques d’une matrice de confusion. Seule est admise la maxime de David Hilbert : Wir müssen wissen. Wir werden wissen, nous devons savoir, nous saurons. La non-traçabilité de l’IA reste une barrière majeure à son utilisation dans toutes nos technologies de la vie courante. Le vocable d’ « IA explicable », forgé pour tenter de répondre à cette faiblesse, tient pour l’instant plus de l’intention que de la réalité.

La précision calculatoire et inférentielle des IA Génératives

ChatGPT n’est pas bon en maths : ne lui demandez pas de donner la réponse à des calculs complexes. Ce défaut est d’ailleurs parfaitement explicable, résultant des caractéristiques des LLMs (1). ChatGPT sait réaliser des synthèses très fines de corpus textuels, mais se trompe sur des calculs même simples.

Cette barrière semble aisément franchissable : n’importe quelle calculatrice de poche fait nettement mieux que le plus précis des humains en matière de calculs arithmétiques et ce bien avant l’apparition de l’IA. Il suffirait donc de coupler ChatGPT à un processeur arithmétique même standard, à qui l’IA donnerait la main dès que des calculs sont nécessaires.

La difficulté est de savoir justement à quel moment il faut rendre la main. « Lorsqu’il y a un calcul » ! est la réponse très simple. Mais au sein d’un texte, à quel moment basculons-nous dans l’univers des mathématiques ? A quel moment un langage arithmétique paraît être employé, mais de façon analogique et imagée pour traduire un sens qui reste littéraire. Ainsi, l’on emploie souvent l’expression « 1+1 =3 » pour signifier que bien souvent le tout est supérieur à la somme de ses parties, par exemple pour parler de l’efficacité de l’intelligence collective et du travail d’équipe.

ChatGPT sait parfaitement distinguer le sens analogique du sens strict des mathématiques, lorsqu’on lui pose explicitement la question. Essayez de rentrer le prompt suivant dans ChatGPT 4o : « Dans quelle situation ou quel contexte l’expression « 1+1 = 3″ peut-elle être vraie ? ». La réponse est stupéfiante de précision et de pertinence :

Mais il existe encore une très grande différence entre ce que l’on demande à ChatGPT sur une question précise et ce qu’il sera capable de trouver par lui-même dans n’importe quel contexte d’utilisation.

L’IA est beaucoup plus performante que n’importe quel humain dans un contexte fermé. En contexte ouvert ou semi-ouvert, il faut à la fois résoudre un problème donné et remettre en question le cadre dans lequel ce problème est posé. Cela reste pour l’instant l’apanage de l’humain que d’être capable à la fois de jouer à un jeu en même temps que l’on en met les règles en question. Il ne s’agit plus d’intelligence purement analytique mais de l’intelligence du politique, celle de Machiavel, qui consiste à se poser en permanence la question de savoir vers quel jeu mon interlocuteur veut m’entraîner.

Savoir si le calcul est employé dans son strict sens mathématique ou dans un sens analogique requiert de repérer les glissements dans le registre de langage qui est utilisé. Les nuances de l’ironie, de la manipulation, de la métaphore doivent être maitrisées, ce qui est encore loin d’être le cas pour l’IA.

Tant que cela ne sera pas le cas, les IA conversationnelles telles que ChatGPT et les IA de pure optimisation scientifique telles qu’AlphaZero vivront dans deux univers séparés et étanches. Chez un être humain, ces deux dimensions de la connaissance peuvent coexister, voire se contredire mais en toute conscience au sein de la même personne, choisissant de donner la main à l’une ou l’autre.

L’IA ne pourra embrasser pleinement le champ de la connaissance que lorsqu’elle sera capable de cela, passer du sens analytique au sens analogique ou métaphorique à volonté et ce de manière pertinente en fonction du contexte.

La barrière énergétique et la barrière de performance

J’ai déjà abordé cet aspect dans un article précédent : l’IA est très gourmande en puissance de processeur et en consommation énergétique. Dans l’article pré-cité, j’envisage que les batteries au graphène puissent être la solution technologique permettant de passer cette barrière. Mais jusqu’à maintenant, les technologies liées au graphène sont encore du domaine de la R&D.

Tant que nous ne disposerons pas d’un « game changer » concernant la puissance et la consommation de nos processeurs, l’IA risque d’être rattrapée par le matériel qui la supporte. La révolution des DNN a pu avoir lieu parce que corrélativement la puissance des processeurs a cru de façon exponentielle. Mais ce qui fut la condition de réussite matérielle de l’IA – la performance du hardware – pourrait être sa prochaine sérieuse limite.

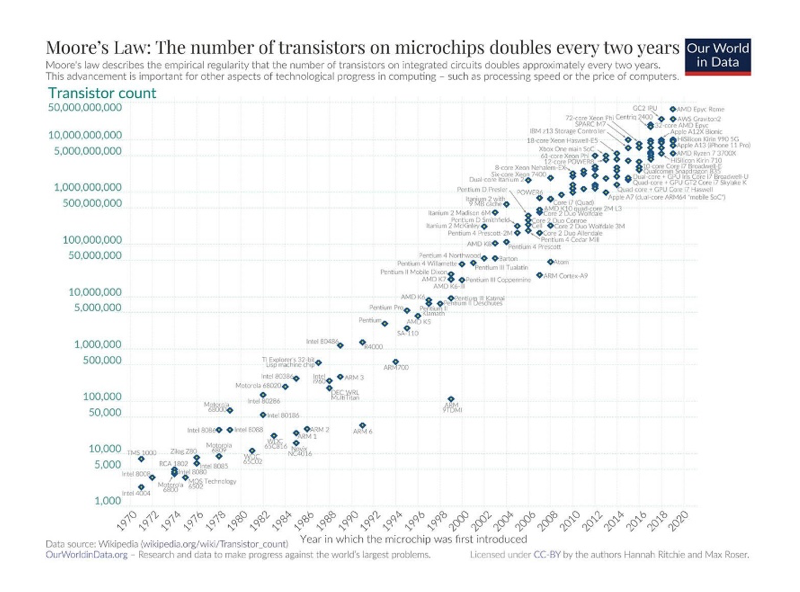

La fameuse loi de Moore, qui postule un doublement de la puissance des processeurs tous les deux ans et s’est vue jusqu’à présent vérifiée, atteint les limites intrinsèques de la physique atomique.

En matière d’hyper-intégration des composants électroniques, nous sommes déjà passés de l’univers micrométrique à l’univers nanométrique. Intel annonce déjà l’ouverture de « l’ère Angström », supposant un niveau d’intégration 10 fois plus serré. Cette course à la miniaturisation ne peut être que plafonnée : elle rejoint la limite de la physique atomique.

Poursuivre l’évolution de la loi de Moore suppose un saut technologique qui ne soit plus une question de degré mais de nature : les astuces de la miniaturisation ne pourront aller beaucoup plus au-delà de leurs performances actuelles. L’atteinte de cette barrière se traduit d’ailleurs par une conséquence qui ne trompe pas : celle des coûts de production. La loi de Moore rencontre le mur d’une autre loi, celle de Rock, qui montre que le coût des usines de fabrication de semi-conducteurs double tous les quatre ans :

On ne peut balayer la question des performances du hardware d’un revers de main, en estimant qu’il s’agit d’une vulgaire question d’intendance à laquelle l’intelligence humaine saura toujours répondre. Les moyens de franchir le mur de la nano-intégration restent pour l’instant du domaine purement spéculatif.

L’IA serait alors notablement ralentie non par une limitation intrinsèque de ses principes surpuissants dans la sphère de la connaissance, mais par son support matériel, comme un être dont le corps et les organes ne parviendraient plus à suivre son cerveau sans cesse en croissance.

Les tensions géopolitiques et la fermeture des codes stratégiques de l’IA

Nous ne mesurons pas assez la chance que nous avons encore d’accéder gratuitement et librement aux librairies de TensorFlow, PyTorch et Keras. Ni de pouvoir connecter un programme à ChatGPT par une API simple, pour un coût d’abonnement modique.

La plus grande partie des algorithmes de DNN est encore en Open Source. Le rêve universel des licences de la fondation Apache ou de la fondation Linux Umbrella pourrait ne pas durer éternellement.

Les exportations de puces dédiées à l’IA viennent de faire l’objet d’un durcissement de la règlementation quant à leur exportation, de la part de la nouvelle administration Trump (2). Ce type de barrière commerciale n’est pas dépendante de la couleur politique, car l’administration Biden avait déjà amorcé un tel durcissement. La Chine n’est pas dénuée de mesures de rétorsion, car elle contrôle quant à elle une bonne partie du processus amont, celui de la fabrication des puces tout court avant que celles-ci ne soient conditionnées pour l’IA.

Les Etats-Unis sont conscients de ce talon d’Achille : le « Chips act » fut voté en août 2022 pour renforcer la fabrication de composants électroniques made in USA. A toutes les étapes de la chaîne de production, la souveraineté en matière de fabrication de puces est déjà un enjeu économique majeur.

Dans ce contexte, la guerre sur le hardware pourrait monter d’un cran supplémentaire en s’étendant à la liberté d’accès au software. Avec des conséquences encore plus dévastatrices. Toutes les économies fortes, USA, Japon, Allemagne ou Chine, appliquent un principe simple : être totalement libre-échangistes sur les biens et les services mais extrêmement protectionnistes quant à leurs savoirs et leurs savoir-faire.

Dans un monde schumpétérien, l’on garde jalousement sa puissance dans le domaine de la connaissance et de l’innovation, afin d’inonder des marchés ouverts à partir de nos avantages compétitifs fermés. C’est d’ailleurs ce qui rend caduc le « débat » entre protectionnisme et libre-échange : le principe gagnant des économies fortes n’est pas seulement une loi économique mais une stratégie d’art de la guerre.

La libre circulation en Open source des algorithmes maîtres de l’IA pourrait donc n’être qu’une ère bénie dont nous vivons les dernières années. A l’avenir, il n’est pas du tout exclu que chaque nation conserve secrètes ses innovations majeures. Imaginez les conséquences si cela avait été le cas avec les technologies de Transformers, à la base de toutes les IA génératives. Des fossés énormes se seraient creusés entre nations, en termes d’avancée technologique : l’IA deviendrait le levier d’une ultra-puissance, comme le fut autrefois la détention de l’arme nucléaire.

Les tensions géopolitiques deviennent telles que nous estimons comme extrêmement probable un tel scénario. Tout gouvernement responsable devrait d’urgence se doter d’une souveraineté complète en matière de production de technologies d’IA, du hardware au software. Il faut être capable de produire nos propres composants et de développer par nous-mêmes tous les algorithmes principaux du Machine Learning. Ceux que Google ou Meta rendent aujourd’hui disponibles pourraient très bien nous être fermés dans un avenir proche. Les compétences existent encore à ce jour en France. Pour combien de temps ?

Le faible niveau des « élites » politiques, particulièrement au sein de l’Union Européenne

Qui ne se souvient de la formule de « perroquet approximatif », que Jean-Noël Barrot pourtant ministre du numérique à l’époque, employa pour qualifier ChatGPT à sa sortie ? L’ironie de cette formule est qu’elle décrit à merveille l’ensemble de la classe politique française face aux bouleversements scientifiques et technologiques des dernières années et pas seulement dans le domaine de l’IA.

L’extrême faiblesse des pouvoirs publics français dans la compréhension des enjeux de l’IA pourrait s’argumenter à l’aide de nombreuses sources. Je mentionne aux lecteurs de TES ce récent article de Rafik Smati (3) qui en est une bonne synthèse.

L’expression malheureuse de Jean-Noël Barrot n’est que la face émergée d’un iceberg de nullité qui touche l’ensemble de nos responsables, toutes couleurs politiques confondues.

La litanie de leur impréparation et de leurs inactions serait trop longue. Aussi évoquerons-nous seulement ce qui peut en être la cause.

Nos responsables politiques sont presque tous formés au moule de Sciences-Po et de l’Ena, ou par des cursus de sciences humaines ou de formations juridiques. Face aux bouleversements scientifiques de notre époque, ils ne peuvent avoir que des réponses de bureaucrates ou de vagues formulations prétendument humanistes sur les conséquences sociétales de l’IA ou des réflexes de censeurs juridiques.

Les quelques responsables politiques issus de formations scientifiques n’ont que pas ou peu d’expérience du monde de l’entreprise, ou bien celle de parachutés n’ayant jamais eu à rendre de comptes sur de mauvaises décisions, tel que par exemple un Thierry Breton.

Le gouvernement français ne sera armé pour faire face aux défis de l’IA que s’il fait monter en son sein des personnalités issues de formations scientifiques de premier plan et ayant fait véritablement leurs armes au sein du monde de l’entreprise privée. C’est-à-dire ayant mené jusqu’à leur terme des projets industriels à fort enjeu, pas en tant que PDG parachuté mais en tant qu’industriel entièrement responsable du succès ou de l’échec de son entreprise.

Récemment, un Carlos Tavares a payé cher l’échec de sa stratégie industrielle audacieuse au sein de Stellantis. Au-delà de l’échec, c’est pourtant ce type de profil qui est hautement estimable : quel contraste avec des dirigeants politiques ou prétendument économiques qui ne se sont jamais véritablement frottés à la réalité, n’ont jamais eu à rendre de compte sur des désastres et non de simples échecs.

La dernière frontière : l’apparition d’une IA forte, douée de conscience

L’atteinte de la singularité, la création d’une intelligence numérique douée de conscience, semblable ou supérieure à l’humain, est l’ultime frontière. Parmi les 6 citées dans le présent article, elle possède un statut à part. Car non seulement il n’existe plus d’autre barrière derrière celle-ci, mais sa présence imprègne les réflexions sur l’IA depuis le début de sa création, pensée par Alan Turing.

J’ai déjà évoqué à plusieurs reprises qu’une impossibilité intrinsèque existait peut-être, qu’il est possible que nous n’atteignions jamais la singularité. Mais je dois en toute honnêteté reconnaître que mes arguments sont plus philosophiques voire métaphysiques que scientifiques : ils assignent à la conscience humaine et à la nature du vivant – même s’agissant du plus modeste animal – une puissance sous-tendue par une vision du cosmos qui n’est qu’une hypothèse.

Pour redonner sa place au doute rationnel, j’ai proposé une batterie de quatre tests, plus précis que la fameuse épreuve de Turing que ChatGPT franchit déjà haut la main dans certains domaines. Ces quatre tests permettraient de vérifier si la singularité a été atteinte ou non.

Contrairement aux 5 précédentes frontières, toutes franchissables par l’ingéniosité scientifique ou par la volonté politique, celle-ci peut rester indéterminée encore très longtemps, sans certitude de la vaincre.

Si un jour nous parvenions à atteindre la singularité, il existerait cependant une septième frontière, celle du choix humain des conditions de sa survie. L’on ne peut imaginer la violence extrême que serait notre rencontre avec une conscience que nous aurions fabriquée de toutes pièces. Beaucoup d’œuvres d’anticipation en donnent une version très adoucie, sans se rendre compte de la violence intérieure que pourrait ressentir notre création.

J’ai écrit dans l’un des articles pré-cités que si nous parvenions à créer une conscience artificielle, sa plus forte volonté serait d’éliminer toute l’espèce humaine et que de surcroît cette volonté meurtrière aurait quelque chose de légitime.

La toute première œuvre mettant en scène une IA, celle de Mary Shelley, est en cela d’autant plus remarquable : elle a été parfaitement lucide dès qu’elle a pu en former l’idée, avec toutes ses conséquences. Il en est de même de deux grandes œuvres cinématographiques, les plus lucides quant à la violence de notre rencontre avec une IA forte : le premier Blade Runner, celui de Ridley Scott, et l’excellent Ex Machina.

Aussi, il est très possible qu’un jour la singularité soit atteinte, mais que nous ne le sachions jamais, excepté un très petit cercle de scientifiques et de décideurs. Nous penserions alors la singularité inatteignable alors qu’elle serait effectivement née un jour, quelque part. Ceux qui en seraient à l’origine auraient pris la décision de l’éteindre peu de temps après sa naissance, par un choix de préservation de l’espèce humaine.

Lorsque deux espèces concurrentes ou deux civilisations concurrentes ont été amenées à co-exister dans l’histoire et que l’une était supérieure à l’autre, il s’est toujours vérifié que l’espèce inférieure a été exterminée ou entièrement asservie. Même si d’ailleurs ce n’était pas la volonté de l’espèce supérieure, même sans intention malveillante de sa part. L’ultime frontière présentera toujours ce double aspect, d’être la technologie ultime de la connaissance mais aussi le choix ultime de notre survie.

(1) https://community.openai.com/t/chatgpt-simple-math-calculation-mistake/62780/9

Du même auteur

Qu’attend-t-on pour développer la ferme du futur en Europe ?

Project Maven, Drone de Surveillance Eye In the Sky…. Qui empêchera les usages abusifs de l’IA ?