« Fantaisie délirante » : la parole du Pr Raoult à l’encontre du Big Data porte la marque provocatrice du célèbre médecin marseillais. Prise au pied de la lettre, elle appelle des critiques légitimes : le professeur marseillais se prive d’outils puissants d’investigation et de preuve.

La pharmacologie et notamment la recherche de nouvelles molécules sont révolutionnées par les techniques de Data Science, faisant passer l’unité de temps pour une découverte de l’année à la semaine. Egalement, les techniques randomisées demeurent les plus efficaces pour éliminer les biais d’expérience.

La Data Science détecte les situations où la réalité scientifique est contraire à l’intuition : c’est le propre de la preuve que de soumettre nos intuitions à des vérifications critiques et la pensée rationnelle ne peut se passer d’une telle mise à l’épreuve.

Pourtant, le Pr Raoult semble moins fâché avec l’emploi des chiffres en médecine qu’avec une certaine utilisation qui en est faite. Il faut une fois encore éviter le simplisme dans ce débat : ce que le Pr Raoult semble craindre est surtout une séparation totalement étanche entre les médecins et les statisticiens, une évolution faisant du médecin un simple exécutant, l’analyse et la preuve étant fournies par les méthodes statistiques de façon mécanique, sans nécessité de connaissances cliniques.

Cette crainte n’est pas propre au professeur marseillais. Elle pose la question de l’automatisation totale de la médecine. Là est le véritable débat posé par sa formule provocatrice.

Scientifiques causalistes et preuve probabiliste

Tout Data Scientist rencontre deux difficultés dans sa profession, face à deux catégories de scientifiques.

La première est la confrontation avec des ingénieurs et scientifiques formés uniquement aux sciences déterministes classiques, dont l’archétype est le physicien. Dans les sciences de l’ingénieur, il s’agit des experts en mécanique, électricité ou électronique.

Pour ces scientifiques, la statistique et le calcul de probabilités ne sont pas de vraies « preuves ». Notamment, la fiabilité d’un système industriel sensible, un avion de ligne, une voiture autonome, une centrale nucléaire, ne saurait être laissée au seul calcul des probabilités. Le Data Scientist est pour eux quelqu’un de suspect, quasiment proche du joueur de Poker et misant les vies humaines au hasard.

Pour un scientifique causaliste, la preuve est du même ordre que la démonstration mathématique : un enchaînement de raisonnements incontestables. Le scientifique causaliste exige de comprendre exactement les mécanismes du système dont il doit mesurer la fiabilité.

S’il s’agit d’un avion, il faudra employer la géométrie de l’aile et son aérodynamisme, la physique des turbines, le fonctionnement des aérofreins, les connexions du réseau électrique activant les commandes de l’appareil. Pour une voiture autonome, les régimes moteur, la physique du freinage et de la liaison au sol, le bus d’information alimentant les calculateurs, les capteurs (caméra, radar, lidar, …) doivent être les éléments de la preuve de fiabilité.

Pour le scientifique causaliste, la statistique est une démission : elle marque le fait que l’on a cessé de comprendre. La statistique est tolérée pour prévoir les flux d’usagers dans les transports en commun ou les pics de consommation d’électricité ainsi que dans les sciences humaines. Mais elle n’est pas la véritable science, tout juste un comptage assez simpliste, et il est hors de question de remettre entre ses mains la tâche critique d’établir une preuve, a fortiori lorsque des vies humaines sont en jeu.

En tant que Data Scientist, j’ai eu souvent toutes les peines à faire admettre à un ingénieur mécatronicien la validité d’un calcul probabiliste de fiabilité. Tant que l’explication physique n’est pas au rendez-vous, une telle démarche ne peut être qu’un manque de rigueur scandaleux.

Le raisonnement d’un causaliste part d’un souci louable : l’exactitude de la démonstration. De fait, il est des domaines scientifiques qui n’ont pas besoin de la statistique. Les sciences de l’ingénieur suffisent. Les lois de la physique classique sont non contextuelles : elles s’appliquent de façon universelle dans un domaine suffisamment large de situations de la vie courante, celles où les vitesses, températures, pression, ne nécessitent pas d’appel à la relativité ou à des remises en cause du modèle atomique.

Le calcul des probabilités commence à être utile et à dépasser un simple diagramme de Pareto, lorsque le phénomène étudié est sujet à de fortes variations contextuelles. Les lois ne sont plus absolument universelles, elles sont valables à un certain degré d’approximation, avec un fin nuancier de variations d’individu à individu.

La médecine fait évidemment partie de ces sciences : elle établit des lois qui doivent être nuancées en fonction de chaque individu et de son état. Parfois même, ce qui était remède pour l’un devient poison pour l’autre, selon ses caractéristiques physiologiques ou génétiques.

Les méthodes statistiques ne sont pas moins rigoureuses que celles des sciences déterministes : elles sont fondées sur les mathématiques de la théorie des probabilités. Enfin, les statistiques sont l’inverse d’une démarche laissée au hasard : au contraire, elles consistent à « dompter » celui-ci, en garantissant que la résultante de tous les facteurs contingents ne dépassera jamais un certain intervalle.

L’aversion du Pr Raoult pour la Data Science m’a immédiatement rappelé ces chocs de culture scientifique. Le Pr Raoult est certainement un grand scientifique causaliste. Pour lui, lorsque l’on fait de la médecine, ce n’est pas le lieu de parler d’intervalle de confiance, de significativité, d’invalidation de l’hypothèse nulle, etc. Il faut parler d’organes, de nerfs, de système endocrinien, de flux sanguin, de cycle de Krebs, d’alvéoles pulmonaires. Voilà qui explique probablement le dédain du professeur marseillais pour l’analyse des données : elle n’est pas de la médecine, elle ne permet pas une explication clinique.

Face au scientifique causaliste, le Data Scientist doit faire preuve d’une bonne dose de raison et d’une encore plus grande d’humour s’il souhaite survivre. Les polémiques se calment généralement en expliquant que la Data Science ne doit pas s’affranchir des modèles déterministes et de leur compréhension. J’incite toujours les jeunes Data Scientists que je pilote à bien connaître le métier industriel pour lequel ils travaillent, à aller sur le terrain, à en comprendre les pratiques, les concepts et le vocabulaire.

Le deep learning est souvent présenté comme capable de traiter de problèmes dont il ne connait rien, uniquement à partir de la donnée, mais il s’agit d’une présentation marketing plus que de science, tout comme certains affirment que la Data Science permettra de se passer de bons développeurs informatiques. Cela est vrai pour des problèmes simples aux règles fermées et circonscrites. Au-delà, la data science ne peut se passer de connaître le sens que les experts donnent au domaine qu’ils maîtrisent.

Les Data Scientists performants sont ceux qui ont une bonne culture et une bonne pratique des sciences déterministes : physique, chimie, biologie et autres. La Data Science ne donne toute sa mesure qu’avec des « modèles mixtes », combinant les équations déterministes du domaine concerné, avec les variations contextuelles que la statistique saura maîtriser et quantifier.

La Data Science n’est pas l’ennemie du raisonnement causaliste : elle étend sa puissance à des domaines instables sur lesquels celui-ci ne peut fixer des lois. Elle apporte des preuves qui n’amoindrissent en rien les connaissances physiques ou chimiques, mais les rendent capables d’affronter d’énormes diversités contextuelles qui lui étaient barrées. Enfin, elle permet de trouver les résultats contre-intuitifs, qui ont souvent une grande valeur parce qu’ils ne sont pas naturels à l’esprit humain. Cela n’a rien d’étonnant : la statistique est fille de la logique. Elle n’est autre que la théorie des ensembles appliquée à un très grand nombre de spécimen.

Les zélotes de la statistique dont le statisticien se passerait bien

La seconde catégorie à laquelle le Data Scientist se confronte semble moins difficile, mais peut provoquer des dégâts scientifiques comparables voire supérieurs.

Il s’agit des prosélytes des méthodes de preuves statistiques, l’on pourrait même dire leurs zélotes. Ils tiennent la position inverse de celle du causaliste, avec les mêmes excès. Ils ne sont jamais des statisticiens professionnels, il s’agit souvent de personnes fraîchement converties aux méthodes probabilistes. L’on y compte également des médecins, qui curieusement prêtent à la statistique des pouvoirs bien supérieurs à ceux que les statisticiens lui reconnaissent.

Ils considèrent que la preuve statistique est le summum de la rigueur, particulièrement lorsqu’elle emploie des techniques de randomisation pour éliminer les biais. L’approche causaliste est jugée trop dépendante du talent et des intuitions du scientifique qui l’applique. La méthodologie statistique parvient pour lui à l’objectivité parce qu’elle n’est pas « human dependant », qu’elle se fonde uniquement sur les données et n’a besoin d’aucun argument d’autorité ou d’intuition. Ironiquement, le Data Scientist se trouve ainsi pris entre deux mâchoires, l’une considérant que la statistique n’est pas sérieuse, l’autre qu’elle est la rigueur absolue.

Le zélote a l’enthousiasme du converti et souvent aussi son intégrisme. Il défend avec d’autant plus de passion la technique qui l’émerveille qu’il en a une vision étroite.

En apparence, une analyse clinique randomisée est chose simple : l’on calcule la significativité et l’intervalle de confiance, l’on rejette ou non l’hypothèse nulle, confirmant ou non l’effet significatif du traitement. Eventuellement la stratification rajoute quelques raffinements.

Les essais randomisés sont présentés comme ayant l’avantage d’être totalement limités dans le temps. Ils ne durent que ce que prend l’essai clinique, délivrent une conclusion circonscrite à l’étude, sans besoin des travaux passés. Dans cette approche naïve, ils sont un élément pur de preuve. Certains les présentent comme les seuls capables d’établir de façon certaine une relation de cause à effet, tandis que toutes les autres méthodes statistiques n’établissent que des corrélations, mélangeant trop d’effet pour démontrer une causalité.

C’est là une vision étroite des RCT. Un calcul de significativité et de rejet ou non de l’hypothèse nulle n’est que le début de la statistique. Les vraies difficultés commencent à la fin de l’essai clinique, lorsqu’il s’agit de savoir s’il est généralisable à une population beaucoup plus vaste, à l’échelle d’un pays voire du monde entier lorsqu’il s’agit d’une pandémie. Toute étude clinique randomisée comprend au moins deux manches : la première qui est l’essai clinique proprement dit, la seconde qui est sa mise à l’épreuve sur de nouvelles populations, avec éventuellement des biais non prévus.

En tentant de généraliser les propriétés observées lors de l’essai clinique, l’on s’aperçoit bien vite que les essais randomisés n’ont pas éliminé les biais de façon absolue : ils ne l’ont fait que localement, sur l’échantillon de population de l’essai. Les RCT sont condamnés à la corrélation et ne démontrent aucune causalité, pas plus que toute autre méthode.

C’est le pain quotidien de celui qui fait du machine learning que d’entraîner son modèle (statistique, neuronal ou autre) sur une base d’apprentissage et d’en tester le pouvoir de généralisation sur des données entièrement nouvelles. Un terme manque souvent à celui qui ne connaît que les RCT dans leur forme étroite, celui de robustesse. Le data scientist passe son temps à alterner l’emploi d’outils prédictifs et d’outils de preuve, avec des remises en question de leurs résultats pour rendre son modèle plus robuste.

Lors de la généralisation, les éventuels nouveaux biais nécessitent une interprétation. L’on ne peut plus compter sur les mécanismes de la randomisation, précisément parce que de nouvelles variables sont apparues. Et comment recale-t-on le modèle ? Comment sortir de ses limites étroites depuis l’intérieur de celui-ci ? Par des appels à l’intuition, au raisonnement causal, à l’observation. Ceux-ci seront à leur tour soumis à une vérification par la preuve, qui présentera encore de nouveaux biais plus fins, que l’on interprétera à nouveau par des hypothèses, etc.

La « méthode scientifique » ne consiste pas en une formalisation qui élimine tout facteur humain et toute intuition. Elle est un balancier incessant entre la preuve formelle et l’hypothèse plus ou moins intuitive. Elle atteint les précisions extraordinaires des sciences non parce que sa démonstration est absolue, mais parce que ce balancier converge de plus en plus, éliminant les hypothèses non pertinentes comme des scories de plus en plus petites.

La mécanisation comme idéal de la rigueur

Le rêve d’une preuve qui aurait éliminé tout ce qui est « human dependant » est connu depuis longtemps, bien avant que la statistique n’existe. L’objectivité absolue serait atteinte si le facteur humain pouvait être totalement éliminé, si la démonstration était menée uniquement par une machine.

En mathématiques, le rêve de la démonstration automatique est apparu très tôt, avec une proximité forte entre preuve et calcul. L’idéal du mathématicien était une sorte de suicide spirituel, consistant à s’effacer de plus en plus totalement pour laisser la place à des opérations entièrement mécaniques, ne pouvant être soupçonnées de subjectivité. La machine devient au passage divinisée, son absence de conscience lui conférant l’objectivité, l’accès à une preuve que l’on peut considérer somme absolue.

La possibilité d’un formalisme total fut le rêve du grand mathématicien David Hilbert. L’impossibilité de son projet fut établie par le premier théorème d’incomplétude de Kurt Gödel, démontrant que dans tout système axiomatique, il existerait des propositions vraies mais non démontrables. La non démontrabilité n’est pas absolue, car il est toujours possible de modifier l’axiomatique pour rendre ces propositions démontrables. Mais ces ajustements font apparaître de nouvelles propositions non démontrables dans la nouvelle axiomatique.

Je ne rentre pas dans la controverse et le débat extrêmement technique de savoir si c’est le premier ou le deuxième théorème d’incomplétude qui met fin au projet de Hilbert. Cette controverse de spécialistes ne modifie pas notre propos.

Le rêve de Hilbert a un équivalent dans le domaine de la statistique, sans doute celui qui fait voir à certains les essais randomisés comme LA méthode parvenant à un absolu démonstratif, saisissant la relation de sa causalité à l’état pur.

Il s’agit de la « bibliothèque infinie du hasard ». Si une série est absolument aléatoire, elle doit renfermer dans sa suite de nombres la totalité des séries finies possibles. Si notamment un encodage fait une correspondance entre les nombres et les lettres, quelque part dans la série aléatoire l’on doit trouver le texte complet de Don Quichotte, puis ailleurs la totalité de la comédie humaine de Balzac dans le désordre et encore plus loin le texte du Quichotte en ayant supprimé la lettre « e », etc.

Si l’on postule que l’une de ces séquences ne se trouve pas dans la série aléatoire, … alors elle n’est plus totalement aléatoire puisque nous avons trouvé une régularité, aussi infime soit-elle. Une série aléatoire contient potentiellement la totalité possible de ce qui peut être écrit, des suites sans aucun sens comme les œuvres complètes de n’importe quel écrivain. Cette magie du hasard et de sa bibliothèque de la totalité des savoirs fascina l’écrivain Jose Luis Borges, qui aborde cette thématique très souvent dans son œuvre.

Cette présentation quasi métaphysique du hasard laisse songeur : elle est à la limite du paradoxe. Et pourtant le raisonnement montrant que toute série doit y être présente n’a pas de faille. La compréhension du hasard total dépasse probablement l’entendement humain. Le pouvoir qui lui est conféré est d’énumérer la totalité des mondes possibles, la variété infinie des contextes qu’il est possible de rencontrer.

L’être humain ne peut produire et utiliser qu’une version tronquée du hasard, localisée et restreinte à une petite population de référence. Un essai randomisé élimine tous les biais… de la population de référence à laquelle il s’applique, le petit échantillon de population d’un hôpital bordelais ou new-yorkais dans lequel l’étude se déroule. Lorsque l’on cherche à élargir les résultats à toute la population mondiale, de très nombreuses nouvelles variables contextuelles apparaissent, sources de nouveaux biais.

Ceux qui prêtent aux RCT un pouvoir absolu de preuve de la causalité confondent sans doute le tirage aléatoire à échelle humaine avec le hasard métaphysique qui fascinait Borges. Exagération ? L’on a vu lors de la crise du COVID des partisans des RCT les présenter comme la seule méthode possible, toute autre nous ramenant à l’époque des rebouteux et de la saignée.

Les labyrinthes de l’indécidable

Depuis les découvertes de Gödel, il n’est plus possible de soutenir sérieusement la possibilité d’une mécanisation totale du raisonnement, dès lors que le problème dont on parle passe un certain seuil de complexité.

La démarche scientifique ne consiste pas à éliminer totalement les facteurs humains que sont l’intuition ou le talent du scientifique, mais à soumettre ces éléments humains au crible de la preuve.

Les outils mathématiques utilisés en science physique par exemple, sont d’une exactitude absolue. En revanche, leur utilisation pour décrire et prévoir un phénomène physique n’est pas totalement mécanisable, elle n’est pas une recette à appliquer infailliblement. Toutes les sciences de l’ingénieur employées pour fabriquer une automobile sont parfaitement exactes. Il n’y a en revanche aucune recette garantissant que la fabrication concrète d’une automobile sera un succès.

Les méthodes employées par toute science ne sont que des outils. La véritable démarche scientifique alterne intuitions humaines et vérifications méthodologiques, débouchant sur de nouvelles questions plus fines abordées par l’intuition, à leur tour soumises à la preuve, etc. Appelons cette alternance de l’intuition et de la preuve : alternance de la démarche scientifique.

Le scientifique alterne ainsi des ouvertures « out of the box » qui dépendent de sa perspicacité et de son talent, avec des tests critiques. La valeur scientifique d’une démarche n’est pas de mettre fin au facteur humain mais de le soumettre au grill.

Ce qu’il est impossible de faire est de prévoir à l’avance à quel moment et comment les appels à l’intuition et les appels à la vérification vont intervenir. Il n’y a pas une méthode de toutes les méthodes. Si cela était le cas, elle serait enseignée d’ailleurs dans tout cursus scientifique et toute science consisterait dans le déroulement infaillible de ses étapes.

L’on ne peut savoir si une démarche est réellement scientifique ou non qu’a posteriori, par la vérification de ses éléments de preuve. Il n’existe aucune méthodologie, aucun algorithme, permettant de savoir à quel moment l’on testera le modèle et à quel moment il faudra sortir du modèle pour le généraliser, penser « out of the box ».

Le plus extraordinaire est que ce résultat se démontre : il est possible de prouver que certains problèmes ne peuvent être résolus par aucun algorithme, quel qu’il soit. Il s’agit de la notion d’indécidabilité au sens de Turing.

Avertissement pour les paragraphes qui vont suivre : l’usage qui va être fait des notions « d’indécidabilité au sens de Turing » et « d’indécidabilité au sens de Gödel » vis-à-vis des tests statistiques médicaux ne prétend pas être une application directe de ces notions. Il a été suffisamment reproché à raison à des auteurs – notamment en sciences humaines – de faire un usage inapproprié et ignorant de ces puissants résultats logiques, pour que nous tombions dans le même travers.

Ces deux sens de l’indécidabilité sont cependant utiles, car ils expriment des concepts aidant à comprendre plus profondément les situations que l’on rencontre lors de tests cliniques, ou intuition et preuve doivent s’alterner. D’autre part, l’usage que nous allons en faire dépasse la simple analogie. Dans la mesure où une RCT est une démonstration mise sous forme d’un calcul en un nombre d’étapes maîtrisées, les deux indécidabilités au sens de Turing et de Gödel peuvent être considérées comme une transposition aux essais cliniques dans le présent article, sans en être une application directe au sens strict.

L’indécidabilité au sens de Gödel nous dit que pour des axiomatiques dépassant une certaine puissance, il

existera toujours des propositions vraies mais non démontrables dans cette axiomatique. L’indécidabilité de Gödel n’est pas absolue, car les propositions non démontrables dans une axiomatique peuvent devenir démontrables en enrichissant l’axiomatique. Mais ce faisant, la nouvelle axiomatique verra apparaître de nouvelles propositions non démontrables.

L’indécidabilité au sens de Turing nous dit que certains problèmes suffisamment complexes ne peuvent être résolus par un algorithme.

Voici un exemple concret tiré des extraordinaires écrits de Jean-Paul Delahaye , un auteur dont nous avons la conviction qu’il sera reconnu comme l’un des meilleurs logiciens et informaticiens contemporains. Par ses travaux, Jean-Paul Delahaye a fait émerger une véritable école de logique et de philosophie analytique en France, rattrapant le retard pris par notre pays sur le monde anglo-saxon. Ses ouvrages et compilations de rubriques de « Pour la Science » devraient figurer dans toute bibliothèque de l’honnête homme du XXIème siècle.

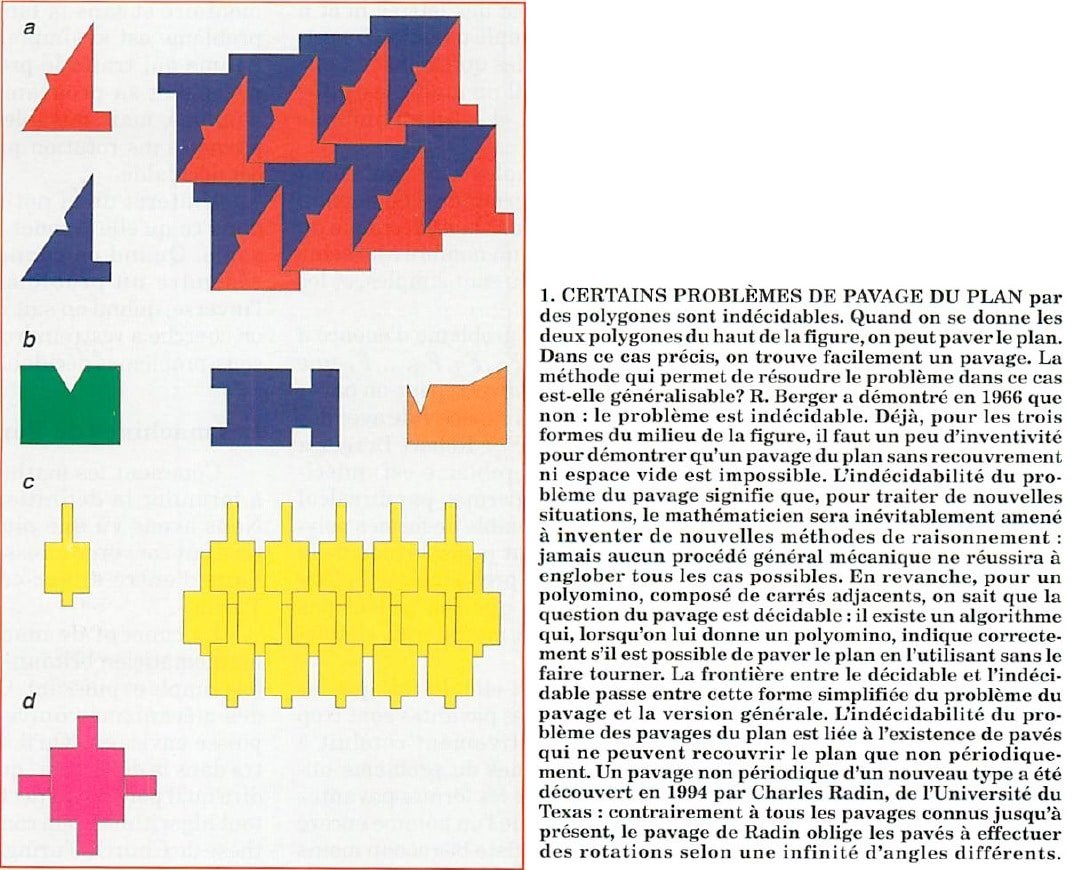

Le pavage du plan par un jeu quelconque de polygones est un problème indécidable : il est impossible d’écrire un algorithme donnant pour résultat l’une des deux valeurs « pavage possible » ou « pavage impossible », s’appliquant à tout jeu de polygones donné.

Les commentaires de JP Delahaye sont éclairants : « Pour traiter de nouvelles situations, le mathématicien sera inévitablement amené à inventer de nouvelles méthodes de raisonnement : jamais aucun procédé général mécanique ne réussira à englober tous les cas possibles… L’indécidabilité du problème des pavages du plan est liée à l’existence de pavés qui ne peuvent recouvrir le plan que non périodiquement… le pavage de Radin oblige les pavés à effectuer des rotations selon une infinité d’angles différents.» : nous avons mis en gras des parties du commentaire qui nous seront particulièrement utiles par la suite.

Transposée aux tests cliniques, l’indécidabilité au sens de Gödel signifierait que des appels à l’intuition seront toujours nécessaires, et l’indécidabilité au sens de Turing qu’il est impossible de savoir à l’avance quand ces appels à l’intuition vont intervenir et quand nous resterons dans l’application d’une méthode de preuve.

Précisons un peu plus avant pourquoi nous nous autorisons une telle transposition. Lorsque nous passons à la seconde phase d’une RCT, c’est-à-dire que nous avons infirmé ou confirmé l’hypothèse nulle sur la population de notre étude et que nous cherchons à la généraliser à des populations plus vastes, la question de la robustesse de nos hypothèses se pose. Il peut apparaître de nouveaux biais statistiques dans la population élargie, parce que les variables sur lesquelles portent ces biais prenaient toutes une seule valeur ou une seule modalité sur la population restreinte de l’étude et que la population élargie montre plus de diversité génétique, physiologique ou de modes de vie.

Les conditions d’application de la RCT restreinte à la population de l’étude sont l’axiomatique de départ. Si nos résultats ne sont pas assez robustes pour être généralisés, c’est-à-dire si des nouveaux biais apparaissent, l’hypothèse nulle est non démontrable, car le biais laissera toujours planer l’ambiguïté de savoir si c’est le traitement ou la nouvelle caractéristique qui est responsable du résultat. Une intuition ou un raisonnement causal seront nécessaires pour supposer quelles sont les nouvelles variables responsables du biais. L’on intégrera ces nouvelles caractéristiques dans l’échantillon de population plus large sur lequel appliquer une nouvelle randomisation : on enrichit l’axiomatique pour rendre démontrable l’infirmation ou la confirmation de l’hypothèse nulle.

L’indécidabilité au sens de Turing nous en dit un peu plus : non seulement des appels à l’intuition seront nécessaires, mais il est impossible de dire à l’avance quand et pourquoi. Comme l’indique JP Delahaye, un problème indécidable nécessite d’inventer de nouvelles méthodes de raisonnement. On ne pourra que vérifier à posteriori que ces méthodes sont valides, mais il n’existe aucune « méta-méthode » permettant de déterminer a priori quelles seront ces nouvelles méthodes à employer.

L’apparition d’indécidabilités dans les essais cliniques semble intimement liée à la variabilité contextuelle qu’il faut affronter. De même que dans l’exemple des pavages du plan, une infinité d’angles pouvait être nécessaire pour parvenir à certains pavages apériodiques, toute démonstration par la randomisation devra affronter potentiellement une infinité de variables cliniques pouvant potentiellement introduire des biais.

Nous n’avons pas accès à échelle humaine au hasard infini qui fascinait Borges et qui permettrait théoriquement de résoudre tous les biais de façon absolue. Nous voyons surgir de nouvelles variables que nous avions considérées implicitement comme neutres dans l’essai de départ, se révélant finalement comme conditionnant le résultat sur une population élargie. L’indécidabilité des essais cliniques provient du fait que leur démonstration absolue nécessiterait de traiter une variabilité infinie de contextes.

Les problèmes de robustesse et de faculté de généralisation de modèles statistiques sont le pendant statistique des problèmes d’indécidabilité logique. Dès lors que la variabilité contextuelle du problème à affronter passe un certain seuil, le problème devient indécidable pour la preuve statistique. A la fois au sens de Gödel – des appels à l’intuition et à inventer un nouveau modèle plus robuste seront nécessaires – et au sens de Turing – ces appels à l’intuition sont non prévisibles, on ne peut savoir à l’avance quand et pourquoi ils interviendront.

En définitive, la frontière entre le décidable et le non décidable dans une méthode de preuve statistique recouvre la distinction que j’opérais dans un précédent article, sur les domaines sémantiquement fermés ou ouverts, c’est-à-dire ceux pour lesquelles la variabilité contextuelle est limité et ceux pour lesquelles elle est explosive :

La rigueur ne nécessite pas le sacrifice de la pensée

La volonté d’objectivité totale ne mène qu’à des paradoxes insolubles. La conscience suprême devient l’absence de conscience. On fait du mécanisme une divinité, comme si la conscience humaine devenait une abomination dont il faudrait se méfier comme de peste.

L’on sait pourtant depuis Popper que la rigueur scientifique ne provient pas d’une pensée « objective » a priori, mais d’une pensée subjective que l’on soumet sans cesse à l’épreuve. L’objectivité ne se retrouve qu’a posteriori, au milieu des modèles qui ont été passés au crible et dont les meilleurs ont survécu. Et ceci ne permet d’atteindre que des degrés d’objectivité, nullement une objectivité valable de façon universelle.

« LA » méthode scientifique ?

Le pire ennemi de la connaissance n’est pas l’ignorance, mais l’illusion de la connaissance.

Si la démarche du professeur Raoult n’est pas exempte de défauts, j’ai pris sa défense parce que ses détracteurs ont fait bien pire que lui, tout en se prévalant de la méthode scientifique.

Il a été reproché au professeur marseillais de s’inspirer de la pensée de Feyerabend. Le philosophe anarchiste de la connaissance ne fait certainement pas partie de mes référents : Karl Popper demeure pour moi le garant non pas de la démarche scientifique mais du critère de démarcation de la connaissance scientifique, ce dernier but étant beaucoup plus humble et beaucoup plus opératoire que le premier.

Le professeur Raoult n’adhère certainement pas au relativisme dans lequel verse Feyerabend, tout dans son discours et son argumentation le démontre. Alors que signifie cet héritage philosophique ?

Sans doute s’agit-il de la partie qu’il faut retenir de Feyerabend : il n’y a pas de méthode pré-établie de la créativité scientifique, et celle-ci n’est jamais entièrement absorbable dans la méthode.

Contrairement à Feyerabend, il faut considérer les méthodes comme bénéfiques et indispensables. Mais elles ne sont pas toute la science. Elles sont l’armature qui permet à la créativité, à l’intuition et au talent de se réguler, la structure qui permet à la pensée de rebondir sur la précision et la réfutation. LA méthode scientifique n’existe pas. Seule l’alternance de la démarche scientifique existe, le dialogue perpétuel entre l’intuition et la méthode, entre la créativité et la règle.

Nul ne peut dire et nul ne pourra jamais dire quand le scientifique lâchera la bride à sa créativité et quand il soumettra celle-ci au crible rigoureux de la méthode. Nul ne pourra prévoir à l’avance quelle nouvelle méthode il devra monter de toutes pièces pour résoudre de nouveaux problèmes imprévus. Si la controverse Raoul a été aussi acharnée, c’est probablement parce que ses racines épistémologiques sont extrêmement profondes, bien qu’elles puissent se résumer en une seule phrase : la médecine n’est pas Turing-calculable. Des racines beaucoup trop puissantes pour la superficialité salonarde de certains mondains de la connaissance, qui se pensent détenteurs de connaissances qui les dépassent largement.

La rigueur ne nécessite pas le sacrifice de la pensée ni de la conscience. Et cela est heureux pour la science et comme le disait le grand Jean Dieudonné, pour l’honneur de l’esprit humain.